Detectores de IA na Educação: Falhas, Consequências e Como Preservar a Integridade Acadêmica

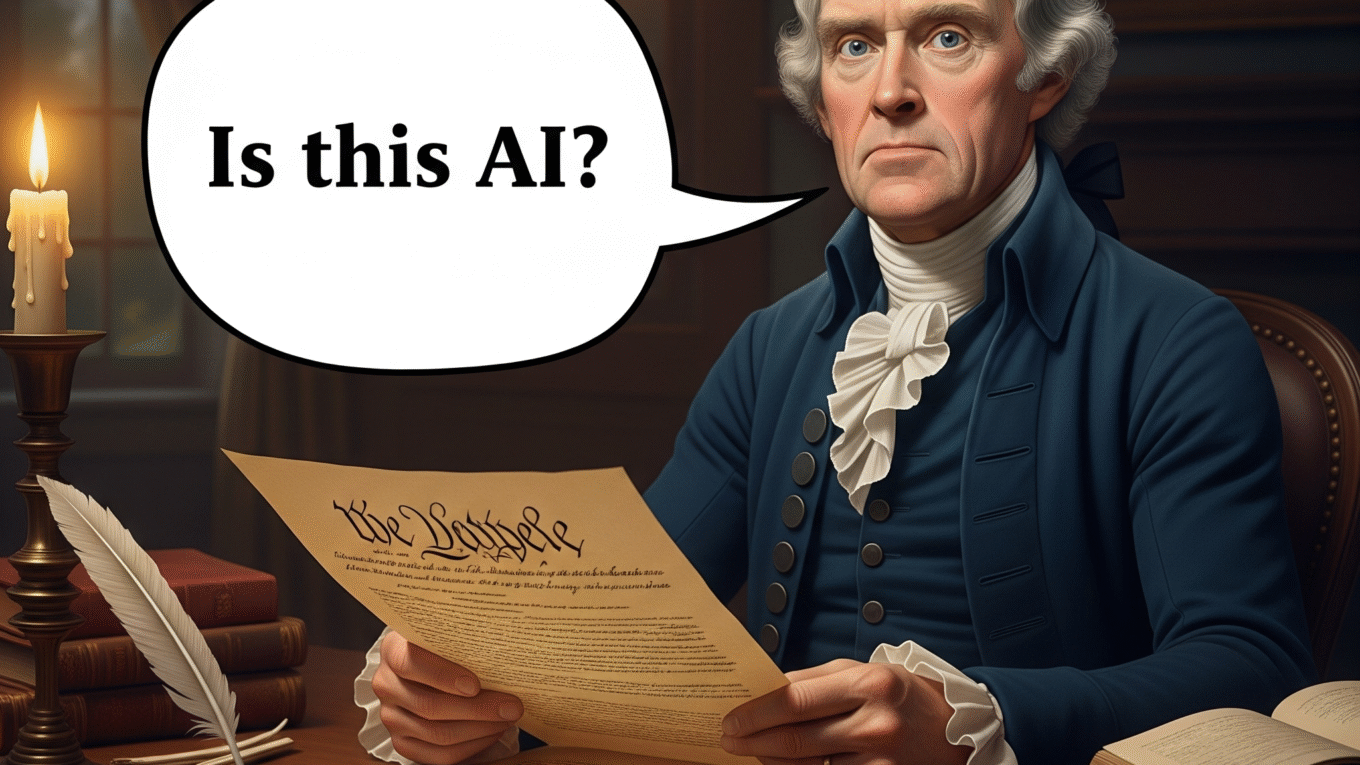

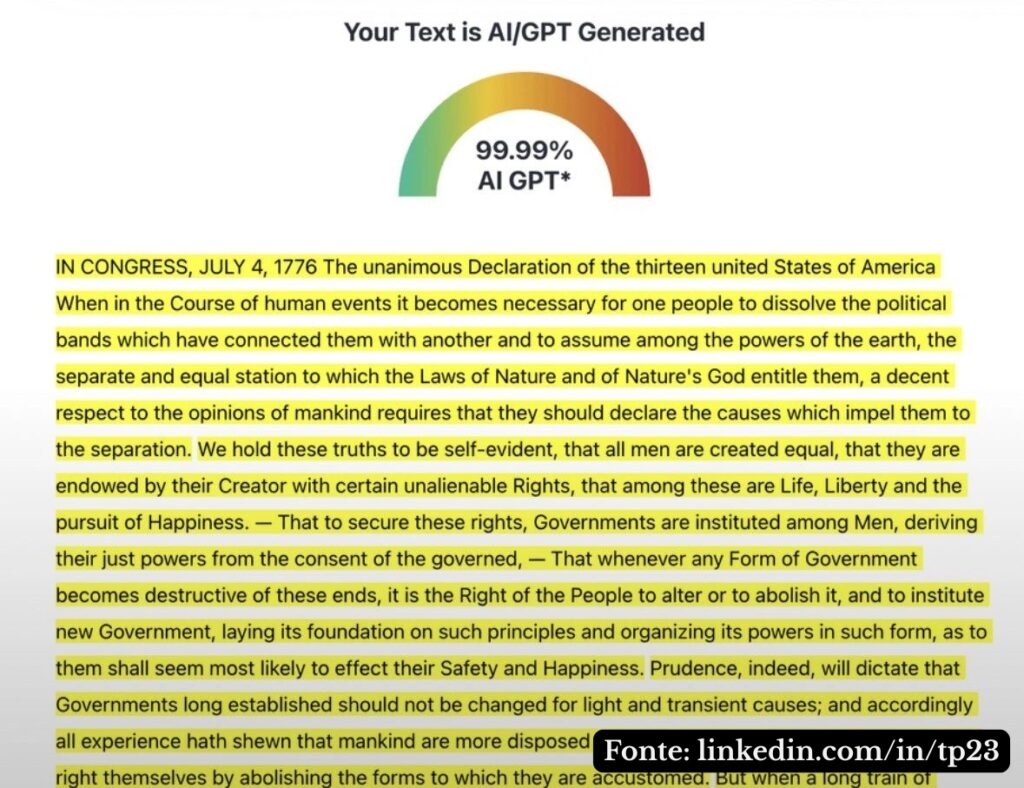

Imagine que você se depara com um trecho histórico tão icônico que moldou a fundação de uma nação — como o discurso da Declaração de Independência dos Estados Unidos — e, acredite, um detector de IA acaba de informar que esse texto centenário foi gerado por inteligência artificial. Pois foi exatamente isso que viralizou nas redes há pouco tempo: uma captura de tela compartilhada por Trung T. Phan mostrando um detector rotulando Thomas Jefferson (ou quem quer que tenha redigido o documento em 1776) como “IA-generated”. A piada à qual ninguém resistiu foi: “Mas que LLM os Pais Fundadores teriam usado?”, uma indagação que expõe, de forma irônica e contundente, o caráter falho dessas ferramentas.

Esse episódio não é um caso isolado. Logo depois, apareceu na internet um artigo bombástico de James D. Walsh para a New York Magazine, intitulado “Everyone Is Cheating Their Way Through College” (“Todo Mundo Está Colando na Faculdade”), com subtítulo ainda mais provocativo: “ChatGPT has unraveled the entire academic project” (“O ChatGPT desmantelou/arruinou todo o projeto acadêmico”). Nele, há relatos de estudantes que simplesmente “mandam ver” no ChatGPT para praticamente todas as tarefas — ensaios de filosofia, análises críticas, até trabalhos sobre culturas indígenas e direito — e em poucos cliques têm notas altíssimas. Professores, por sua vez, correm para “proteger” suas avaliações, migrando para provas escritas à mão, exames orais e missões consideradas “à prova de IA”.

Estas narrativas revelam um ponto central: os detectores de IA, longe de seres infalíveis, frequentemente geram falsos positivos (marcando textos humanos como artificiais) e sentenças absurdas (como dizer que um clássico de 1776 “é obra feita por IA”). Em meio a esse debate, surge a pergunta que vai guiar nosso blog post: como as instituições de ensino, os educadores e os próprios estudantes devem lidar com essa revolução tecnológica que ameaça não apenas a forma de escrever e de avaliar, mas também a própria essência do que significa aprender e pensar de maneira crítica?

Nos próximos parágrafos, vamos mergulhar nessa polêmica: entenderemos por que detectores de IA podem ser enganosos, exploraremos as consequências práticas para universidades e alunos — especialmente aqueles que não têm o inglês como língua nativa ou que seguem estilos de escrita neuroatípicos — e discutiremos possíveis caminhos para preservar a integridade acadêmica sem sucumbir ao pânico tecnológico. Afinal, se até a Declaração de Independência dos EUA pode cair numa armadilha de “falso positivo”, é hora de questionar: será que estamos avaliando o aprendizado ou apenas confiando em algoritmos falíveis?

Por que os detectores de IA ainda são enganosos

A maioria dos detectores de IA baseia-se em padrões estatísticos de frequência de palavras, estruturas sintáticas e assunções de “fluidez” típicas dos modelos. Porém, esses algoritmos acabam sinalizando como “gerado por IA” qualquer texto que esteja bem estruturado demais, que apresente um vocabulário neutro e consistente ou cuja coesão ultrapasse a média de textos amadores. Ou seja, um estudante com excelente domínio gramatical (ou simplesmente com bons hábitos de revisão) já corre o risco de sofrer um falso positivo.

O caso da Declaração de Independência, que ficou famosa justamente por seu estilo claro e objetivo, ilustra bem o problema: apesar de ter sido redigida em 1776, um detector moderno a rotulou como “texto de IA”. Isso mostra o caráter arbitrário dessas ferramentas, que não conseguem distinguir conteúdo humanamente inteligente de texto “treinado” em imensos corpos de dados.

Além disso, existe toda uma problemática relacionada à escrita neuroatípica. Quando falamos em neuroatipicidade, referimo-nos a estilos cognitivos distintos — por exemplo, pessoas com TDAH, dislexia, autismo ou outras condições que afetam a forma de processar, organizar e expressar ideias. Quem escreve de maneira neuroatípica muitas vezes tem construções frasais não convencionais: podem usar menos conectivos, saltar de um conceito a outro ou apresentar repetições que ajudam na autorregulação do pensamento. Esses traços tornam o texto humano mais vulnerável para um ser acusado como feito por IA. Pois esses detectores de IA costumam buscar uniformidade e padrões regulares. Assim, um estudante neuroatípico pode ser penalizado por sua própria forma de pensar — e infelizmente a diversidade cognitiva não costuma ser ser tão valorizada no ambiente acadêmico brasileiro.

Consequências práticas para a Educação

- Falsos positivos e injustiças acadêmicas:

Alunos que escrevem bem, aqueles com domínio de línguas estrangeiras ou escrita neurotípica — e mesmo os neuroatípicos — podem ter seus textos indevidamente acusados de uso de IA, como o ChatGPT. Isso gera desgaste ou desconfiança no processo avaliativo. Professores, que se veem obrigados a “defender” cada caso, podem até desistir de avaliar quanto ao uso indevido de IA. É fato que nem sempre o professor conseguirá discernir se foi usado IA ou não. - Prejuízo a estudantes dos EUA e que não possuem o inglês como língua materna:

Quando uma pessoa estuda nos EUA e cujo primeiro idioma não é o inglês produz redações claras em inglês, os detectores podem enxergar “padrões perfeitos demais”. Até porque é muito comum os EUA importar estudantes que tiveram uma base em gramática inglesa muito melhor do que os nativos estadosunidenses. E acredite se quiser… A educação básica nos EUA, muitas vezes deixa a desejar. - Mudança forçada nos métodos de avaliação:

Para evitar erros, muitas instituições migram para provas presenciais, exames orais ou atividades em sala, reduzindo o peso de trabalhos para casa. Embora isso possa parecer uma medida necessária, acaba penalizando quem não tem condições de comparecer presencialmente (por exemplo, estudantes que trabalham ou moram em regiões distantes). - Retorno de “pânico tecnológico” já vivenciado no passado:

Em meados dos anos 1960, professores de matemática protestaram contra o uso de calculadoras, vendo nelas uma ameaça à capacidade dos alunos de aprenderem operações básicas. Se quiser revisitar essa história e ver analogias com o momento atual, confira nossa postagem anterior sobre o assunto.

Assim como naquela época, a solução definitiva não é proibir a tecnologia, mas sim integrá-la de forma pedagógica. Vale muito a pena a leitura!

Como preservar a identidade acadêmica?

- Alinhar avaliação e ensino:

Antes de impor um detector ou mudar de método, pergunte: que habilidades estou realmente avaliando? Se for escrita, é preciso ensinar redação ao longo do curso; se for pensamento crítico, use debates, seminários e projetos interdisciplinares; se for conhecimento específico, aplique provas objetivas e orais que realmente incentive o pensamento crítico. - Encorajar transparência no uso de IA:

Em vez de punir, peça que o aluno anexe o histórico de prompts e interações com o chatbot como parte da entrega. Assim, o docente pode avaliar o processo de pesquisa, a evolução de ideias e o próprio pensamento crítico, e não apenas o texto final. - Avaliar projetos e portfólios contínuos:

Dê peso maior a trabalhos desenvolvidos ao longo do semestre, com etapas intermediárias — proposta, pesquisa, rascunho, revisão e apresentação final. Dessa forma, o uso de IA pode ser um suporte, mas o aluno precisa demonstrar esforço, reflexão e originalidade em cada fase. Até porque, é bem provável que o mercado de trabalho incentive que profissionais usem a IA como um suporte de otimização de processos. - Conscientizar sobre práticas éticas de IA:

Explique que a ferramenta é parceira, mas não substitui o raciocínio. Estimule o aluno a questionar respostas geradas pela IA, checar fontes e adicionar sua própria voz ao texto.

Conclusão

Os detectores de IA podem até sinalizar padrões estatísticos, mas dificilmente compreenderão o contexto humano, a diversidade de estilos de escrita ou a originalidade de um processo de criação. Para evitar injustiças e manter a integridade acadêmica, o caminho menos tortuoso é repensar a avaliação como um processo contínuo, colaborativo e transparente, em vez de uma “sentença automatizada” baseada em algoritmos imperfeitos.